Prompt-Engineering – wie sag’ ich’s der KI? So verbessern Sie die Kommunikation mit der Künstlichen Intelligenz

Was vor Kurzem noch wie Science-Fiction klang, ist heute Realität: Maschinen, die lernen, denken und sogar kreativ sein können.

Doch wie kommuniziert man mit der KI? Wie bringt man sie dazu, genau die Inhalte zu erzeugen, die man im Kopf hat? Denn eine KI denkt nicht wie ein Mensch – sie erkennt Muster in Daten. Deswegen braucht es eine andere Art der Kommunikation. Und genau hier setzt die Technik des Prompt Engineerings an.

Was ist Prompt-Engineering?

Man kann sich ein KI-Modell wie ein allwissendes Kleinkind vorstellen. Es hat Zugriff auf unfassbar viel Wissen – braucht aber klare Hinweise, um dieses Wissen im richtigen Kontext und sinnvoll zu nutzen.

Prompt-Engineering bezeichnet genau diese Technik: der KI die richtigen Fragen zu stellen, um die besten Antworten zu bekommen. Dazu gehört auch die Fähigkeit, den passenden Rahmen zu setzen – also der KI zu zeigen, in welchem Zusammenhang ihre Antwort stehen soll.

Herausforderungen beim Prompt-Engineering

Prompt-Engineering ist eine sehr junge Technik. Obwohl sie auf den ersten Blick leicht erlernbar wirkt, bringt sie im Kontext der technischen Redaktion zahlreiche Herausforderungen mit sich:

Qualität der Antworten

Eine der größten Herausforderungen beim Arbeiten mit KI-Modellen ist die oft unvorhersehbare Natur der Antworten. Sie können langatmig, unstrukturiert oder vom Thema abschweifend sein – gerade im technischen Kontext ist das ein Problem.

Ein weiteres Problem ist das sogenannte Halluzinieren. Dabei erzeugt die KI plausibel klingende, aber inhaltlich falsche Informationen, die auf den ersten Blick nicht als solche erkennbar sind.

Komplexität der Aufgabenstellung

Aufgaben im technischen Kontext sind meist komplex und mehrstufig. Mit einem einfachen Prompt erhält man in der Regel keine zufriedenstellende Antwort.

Qualität der Datengrundlage

Eine KI kann nur auf der Basis dessen lernen, was vorhanden ist. Ist die Datengrundlage zu klein, unspezifisch oder mehrdeutig, liefert die KI entsprechend ungenaue Ergebnisse.

Methoden beim Prompt-Engineering: So geht‘s

Es gibt jedoch ein paar Methoden, mit denen man Prompts so formuliert, dass die KI bessere Ergebnisse liefert:

Zero-Shot-Methode

Bei der Zero-Shot-Methode löst die KI eine Aufgabe, ohne zuvor ein Beispiel gesehen zu haben. Sie greift dafür auf ihr allgemeines Wissen und Kontextinformationen zurück. Diese Methode ist sinnvoll, wenn Sie keine Beispieldaten zur Verfügung haben. Oft handelt es sich hierbei um einen ersten Entwurf, auf dem dann weitere Techniken aufbauen.

Beispiel:

"Erstelle eine Sicherheitswarnung für ein Hochdruckreinigungsgerät."

- Die KI erzeugt auf Basis ihres Allgemeinwissens und typischer Sicherheitsformate eine passende Warnung – ohne dass Sie ein Beispiel geliefert haben. Das Ergebnis:

⚠ Sicherheitswarnung – Hochdruckreiniger

Achtung! Unsachgemäße Verwendung kann zu schweren Verletzungen oder Sachschäden führen.

One-Shot-Methode

Die One-Shot-Methode bedeutet, dass die KI eine Aufgabe löst, nachdem sie genau ein Beispiel gesehen hat. Wenden Sie diese Methode an, wenn Sie Schwierigkeiten haben, mehrere Beispiele bereitzustellen, wenn es schnell gehen muss, oder wenn es mit Zero-Shot nicht geklappt hat. Ein Beispiel zu geben, kann das Ergebnis verbessern.

Beispiel:

Sie geben der KI dieses Beispiel: "Warnung: Tragen Sie Schutzhandschuhe, um Verletzungen durch heiße Oberflächen zu vermeiden."

Dann bitten Sie: "Erstelle eine ähnliche Warnung für das Arbeiten mit Stromleitungen."

- Die KI überträgt das Muster auf den neuen Kontext und liefert folgendes Ergebnis:

⚠ Warnung: Lebensgefahr durch Stromschlag!

Arbeiten an Stromleitungen nur mit geeigneter Schutzausrüstung und abgeschalteter Stromzufuhr durchführen.

Few-Shot-Methode

Bei der Few-Shot-Methode liefern Sie der KI einige wenige Beispiele mit (meist 2-10), bevor sie eine Aufgabe bearbeitet. Mit beispielhaftem Input und Output helfen Sie der KI, den Kontext besser zu verstehen.

Beispiel:

Sie geben der KI drei Beispiele für Anwendungsbeschreibungen aus einem Produkthandbuch, etwa:

- "Zum Einschalten des Geräts drücken Sie den Netzschalter für 3 Sekunden."

- "Zum Wechseln des Akkus öffnen Sie die Rückseite des Geräts."

- "Zum Verbinden mit WLAN öffnen Sie das Menü Netzwerkeinstellungen."

Dann sagen Sie: "Schreibe eine Anwendungsbeschreibung für das Zurücksetzen auf Werkseinstellungen."

- Die KI erkennt das Format und liefert eine konsistente Beschreibung:

"Zum Zurücksetzen auf Werkseinstellungen öffnen Sie das Menü System und wählen Sie die Option Werkseinstellungen zurücksetzen."

Prompt-Chaining

Beim Prompt-Chaining verwenden Sie mehrere Prompts nacheinander, um eine komplexere und genauere Antwort zu erzeugen. Diese Methode nutzt die Fähigkeit der KI, aufeinanderfolgende Eingaben zu verarbeiten und schrittweise zu einer Lösung zu gelangen.

Schritt für Schritt zur besseren KI-Antwort mit Prompt-Chaining

Prompt-Chaining ist ein iterativer Prozess zur Weiterentwicklung von Prompts, bei dem die Antwort der KI Schritt für Schritt verfeinert wird. Besonders hilfreich ist diese Methode, wenn eine komplexe Aufgabe nicht in einem einzigen Prompt gelöst werden kann. Stattdessen wird sie in kleinere, besser steuerbare Teilaufgaben zerlegt. So lassen sich gezielte Zwischenziele definieren, die als Stellschrauben dienen, um die Qualität der finalen Antwort deutlich zu verbessern.

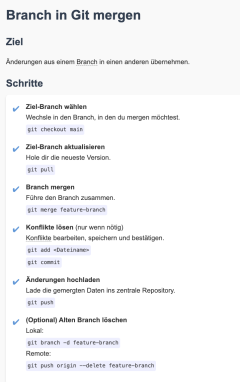

Ein typisches Einsatzszenario: Sie möchten eine Handlungsanweisung darüber schreiben, wie man einen Branch in Git merged. Statt dies in einem einzigen Prompt zu erfragen, kann man den Prozess aufgliedern – etwa in die Vorbereitung des Repositories, das Identifizieren des Ziel-Branches und schließlich den Merge-Vorgang selbst. Mit jeder Iteration wird der Prompt spezifischer, was zu präziseren und nützlicheren Antworten führt. Den gesamten Chatverlauf finden Sie nach Punkt 3 (Ausgabeformat definieren).

1. Frage stellen

Erster Prompt: "Schreibe eine Handlungsanweisung zu folgendem Thema: Branch in Git mergen."

→ Es soll eine konkrete Anleitung entstehen.

2. Kontext hinzufügen

Zweiter Prompt: "Schreibe eine nummerierte Handlungsanweisung zu folgendem Thema: Branch in Git mergen. Die Zielgruppe sind Git-Anfänger. Schreibstil: Minimalismus. Erkläre Fachbegriffe in einer Terminologie."

→ Fügt Kontext, Zielgruppe und Schreibstil hinzu.

3. Ausgabeformat definieren

Dritter Prompt: "Gib den Inhalt als HTML-Seite aus, mit einfachem CSS-Styling. Die Erklärungen sollen als Tooltip angezeigt werden."

→ Infos zum Ausgabeformat.

4. Beispiel mitgeben

Im letzten Schritt könnten Sie zusätzlich ein konkretes Beispiel mitgeben – etwa wie eine HTML-Ausgabe aussehen soll oder wie Begriffe erklärt werden sollen. Wir haben ChatGPT gebeten, eine responsive Seite zu erstellen und die Schritte mit kleinen Icons zu versehen. Chatverlauf ansehen

Diese Schritte lassen sich flexibel anwenden – eine "richtige" Reihenfolge gibt es nicht. Aber: Die Ergebnisse können sich stark unterscheiden.

Dies ist eine weitere Erkenntnis im Prompt-Engineering: Es gibt keine universell gültigen Regeln. Ausprobieren, Testen und ständiges Anpassen sind wesentliche Bestandteile des Prozesses. Was in einem Fall gut funktioniert, kann in einem anderen nicht passen.

Best Practices für Prompt-Engineering

Zusammengefasst können wir folgende Best Practices für das Prompt-Engineering ableiten:

- Gehen Sie iterativ vor: Die erste Antwort ist selten die beste. Tasten Sie sich Schritt für Schritt an das gewünschte Ergebnis heran.

- Formulieren Sie kurz und klar: Je präziser Ihr Prompt, desto weniger Spielraum gibt es für Interpretation und Missverständnisse durch die KI.

- Definieren Sie Kontext über Rollen: Sagen Sie der KI, aus welcher Perspektive sie schreiben soll, z.B. „Du bist ein Technischer Redakteur“.

- Überprüfen Sie die Antworten: Die KI liefert keine gesicherten Fakten, sondern wahrscheinliche Aussagen auf Grundlage ihres Trainings. Es ist unsere Aufgabe, die Ergebnisse zu prüfen.

- Passen Sie Ihr Vorgehen ständig an: Es gibt kein "richtig" oder "falsch". Prompt-Engineering lebt vom Ausprobieren, Testen und Anpassen.

Wann lohnt sich der Einsatz von Prompt Engineering?

Ob sich Prompt-Engineering lohnt, hängt vom konkreten Anwendungsfall ab. Grundsätzlich halten wir folgende Szenarien für besonders geeignet:

- Wiederkehrende Aufgaben: Bei regelmäßig anfallenden Aufgaben lohnt sich Prompt-Chaining besonders. Ein gut formulierter Prompt kann gespeichert und wiederverwendet werden – das spart Zeit und sorgt für gleichbleibende Qualität. Gespeicherte Prompts lassen sich auch leicht mit anderen teilen, die ähnliche Aufgaben haben – ideal für effizientes, kollaboratives Arbeiten mit KI.

- Spezifische Anwendungsfälle: Setzen Sie passende Prompts gezielt ein, wenn der Anwendungsfall klar definiert ist. So erhalten Sie schnell und zuverlässig sinnvolle Ergebnisse.

- Fehlende technische Expertise: Auch Nutzer:innen ohne technisches Fachwissen können mithilfe getesteter Prompts KI-Systeme effizient nutzen und komplexe Themen bearbeiten.

Fazit

Prompt-Engineering ist eine wichtige Methode, um die Interaktion mit KI-Systemen zu verbessern. Wenn wir unsere Fragen (Prompts) sorgfältig planen und und die Ergebnisse immer wieder verbessern, werden die Antworten der KI genauer und nützlicher. Aber es bleibt wichtig, die Grenzen dieser Technik zu kennen und stets kritisch zu überprüfen, ob die KI die gewünschten Ergebnisse liefert.

Sehen Sie hier die Aufzeichnung des Vortrags "Prompt-Engineering – wie sag' ich's der KI?" von Helle Hannken-Illjes und Lukas Jetzig bei der gdslive 2024.